در چشمانداز دائماً در حال تحول بازاریابی دیجیتال، درک پیچیدگیهای بهینهسازی موتور جستجو (سئو) برای هر وبسایتی که هدف آن افزایش دید آنلاین خود است، بسیار مهم است. در این مطلب از سری مطالب آموزشی وبلاگ پارس وی دی اس به Crawl Budget چیست و چگونه آن را برای سئو بهینه کنیم؟ میپردازیم.

یکی از جنبههای اساسی که اغلب نادیده گرفته میشود، مفهوم نرخ خزیدن Crawl Budget است. این اصطلاح به تعداد صفحاتی که یک موتور جستجو در یک وبسایت در یک بازه زمانی مشخص میخزد و فهرست میکند، اشاره دارد.

بهینهسازی نرخ خزیدن میتواند به طور قابلتوجهی بر عملکرد سایت شما در نتایج جستجو تأثیر بگذارد و اطمینان حاصل کند که مهمترین صفحات شما اولویتبندی شده و به طور مؤثر ایندکس میشوند.

در این مقاله، اهمیت نرخ خزیدن را بررسی میکنیم، عواملی را که بر آن تأثیر میگذارند را بررسی میکنیم و استراتژیهای عملی برای کمک به شما در به حداکثر رساندن پتانسیل آن ارائه میکنیم. چه یک متخصص باتجربه سئو باشید یا یک تازهوارد در حوزه بازاریابی دیجیتال، درک و مدیریت نرخ خزیدن خود برای دستیابی به رشد پایدار آنلاین ضروری است. با ما همراه باشید.

Crawl Budget چیست؟

Crawl Budget (نرخ خزیدن) به تعداد صفحات وبسایتی که موتورهای جستجو مانند گوگل در یکزمان خاص میتوانند خزیده و ایندکس کنند، اشاره دارد. این مفهوم برای وبسایتهای بزرگ و با محتوای زیاد اهمیت ویژهای دارد، زیرا تعیین میکند که چه تعداد از صفحات سایت شما ممکن است در نتایج جستجو نمایش داده شوند.

عوامل مختلفی بر Crawl Budget تأثیر میگذارند، از جمله:

اعتبار دامنه: وبسایتهایی بااعتبار بالاتر معمولاً Crawl Budget بیشتری دارند.

سرعت بارگذاری صفحات: اگر صفحات سایت شما به طور سریع بارگذاری شوند، موتورهای جستجو میتوانند بیشتر خزیده و ایندکس کنند.

ساختار سایت: ساختار منطقی و کاربرپسند وبسایت میتواند به موتورهای جستجو کمک کند تا صفحات را بهتر پیدا کنند.

تعداد لینکهای داخلی: لینکهای داخلی میتوانند به موتورهای جستجو کمک کنند تا صفحات جدید را پیدا کنند و خزیدن را تسهیل کنند.

تعداد صفحات با محتوای تکراری یا بیکیفیت: صفحات با محتوای تکراری یا بیکیفیت میتوانند Crawl Budget را هدر دهند.

مدیریت Crawl Budget بهینه میتواند به بهبود ایندکسشدن صفحات و در نتیجه افزایش ترافیک ارگانیک کمک کند.

نرخ خزیدن توسط دو عامل اصلی تعیین میشود: محدودیت سرعت خزیدن و تقاضای خزیدن.

محدودیت نرخ خزیدن: این حداکثر فرکانسی را نشان میدهد که گوگل میتواند وبسایتی را بدون غلبه بر سرور بخزد. اگر سایتی دیر پاسخ میدهد یا مشکلات عملکردی داشته باشد، ممکن است گوگل نرخ خزیدن را کاهش دهد تا فشار زیادی به سرور وارد نشود.

تقاضای خزیدن: این مورد تحتتأثیر محبوبیت سایت، تازگی محتوای آن و تعامل کلی کاربر است. وبسایتهایی که مرتباً بهروزرسانی میشوند، ترافیک بالایی دارند و دارای محتوای مرتبط و مورد تقاضا هستند، نرخ خزیدن بیشتری دریافت خواهند کرد. بهعنوانمثال، وبسایتهای خبری یا وبلاگهایی که مقالات بهموقع منتشر میکنند، معمولاً در مقایسه با سایتهای ثابت، نرخ خزیدن بالاتری دارند.

نرخ خزیدن اساساً تعیین میکند که گوگل چگونه یک وبسایت را به طور گسترده و مکرر ایندکس کند، که مستقیماً بر عملکرد سئو و دیدهشدن آن در نتایج جستجو تأثیر میگذارد.

چرا Crawl Budget برای سئو مهم است؟

فرایند خزیدن حیاتی است؛ زیرا تعیین میکند کدام صفحات برای نمایش در نتایج جستجو در دسترس هستند. اگر صفحهای خزیده نشود، نمیتواند در نتایج جستجو ظاهر شود، که میتواند چندین پیامد منفی داشته باشد:

محتوای مهمی که ممکن است نادیده گرفته شود: نرخ خزیدن محدود باعث میشود که موتورهای جستجو نتوانند عمیق یا مکرر یک سایت را کاوش کنند و احتمالاً صفحات ارزشمند را نادیده میگیرند.

محتوای قدیمی: صفحاتی که در یک وبسایت وجود دارند ممکن است در فهرست جستجو بهروزرسانی نشوند، که منجر به عدم دقت در آنچه کاربران هنگام جستجوی موضوعات مرتبط میبینند، میشود.

کمتر دیدهشدن جستجو: با تعداد کمتری صفحات ایندکس شده، دید کلی وبسایت در نتایج جستجو کاهش مییابد، که میتواند بر ترافیک ارگانیک تأثیر بگذارد.

ازدستدادن بالقوه ترافیک ارگانیک: اگر صفحات مهم خزیده و نمایه نشوند، سایت در معرض خطر ازدستدادن ترافیک ارزشمندی است که میتواند از آن صفحات باشد.

بهروزرسانی محتوای ناکارآمد: محتوای جدید اضافه شده ممکن است موردتوجه موتورهای جستجو قرار نگیرد و فرصتهای تعامل و ترافیک کاربر را کاهش دهد.

اعتبار سایت در معرض خطر: نمایهسازی ناقص ممکن است بر اعتبار درک شده و ارتباط سایت تأثیر بگذارد و به طور بالقوه بر رتبهبندیها در سراسر صفحه تأثیر بگذارد.

چگونه Crawl Budget خود را بررسی کنید؟

نظارت بر نرخ خزیدن سایت شما برای شناسایی مشکلات احتمالی نمایهسازی ضروری است. اگر وبسایتی بزرگ با صدها هزار صفحه را اداره میکنید، اما Google روزانه تنها بخش کوچکی از آن صفحات را میخزد، بهروزرسانیهای مهم سایت شما ممکن است برای مدت طولانی موردتوجه قرار نگیرند. در اینجا چگونه میتوانید نرخ خزیدن خود را بررسی کنید:

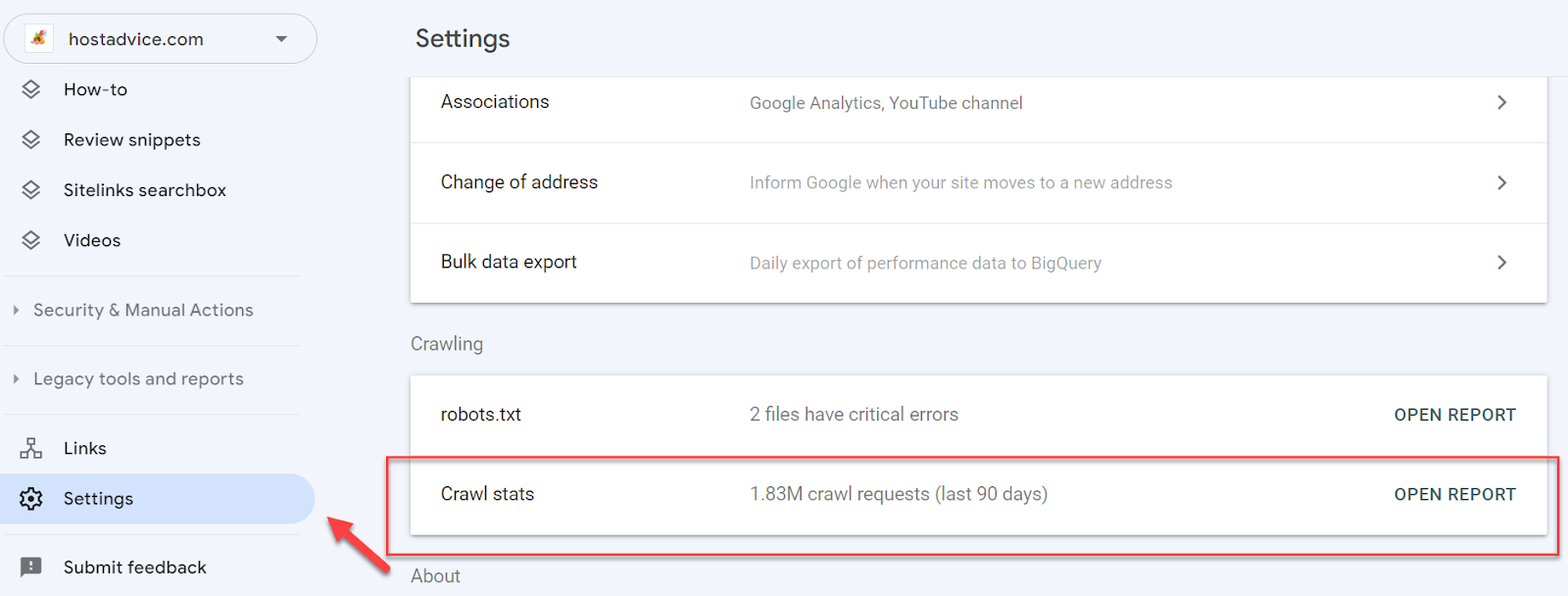

از کنسول جستجوی گوگل استفاده کنید: کنسول جستجوی گوگل (GSC) ابزار اصلی برای بررسی نرخ خزیدن وبسایت شما است.

دسترسی به Crawl Stats: در GSC، به بخش Settings بروید و سپس به گزارش Crawl Stats بروید. این گزارش اطلاعاتی در مورد تعداد صفحات خزیده شده، زمان صرف شده برای خزیدن و مشکلات احتمالی که میتواند بر نرخ خزیدن شما تأثیر بگذارد ارائه میدهد.

گزارشهای سرور را تجزیهوتحلیل کنید: گزارشهای سرور خود را مرور کنید تا ببینید Googlebot چند بار از سایت شما بازدید میکند و کدام صفحات در حال خزیدن هستند. این میتواند به شما در شناسایی الگوها و مناطقی که ممکن است به بهبود نیاز باشد کمک کند.

نظارت بر وضعیت نمایهسازی: از گزارش پوشش شاخص در GSC استفاده کنید تا ببینید کدام صفحات ایندکس شدهاند و آیا خطایا هشداری وجود دارد که ممکن است بر خزیدن و نمایهسازی تأثیر بگذارد.

بهینهسازی ساختار سایت: اطمینان حاصل کنید که وبسایت شما ساختاری واضح و منطقی دارد. اجرای یک استراتژی پیوند داخلی قوی میتواند به موتورهای جستجو کمک کند تا محتوای مهم را پیدا کرده و اولویتبندی کنند.

کاهش محتوای تکراری: محتوای تکراری را به حداقل برسانید تا به موتورهای جستجو کمک کنید روی صفحات منحصربهفرد و ارزشمند تمرکز کنند. از تگهای متعارف برای سیگنال دادن به نسخههای ترجیحی صفحات استفاده کنید.

با نظارت دقیق بر نرخ خزیدن خود و انجام اقدامات پیشگیرانه برای بهینهسازی آن، میتوانید دید و عملکرد وبسایت خود را در نتایج موتورهای جستجو افزایش دهید و در نهایت ترافیک ارگانیک بیشتری را به سایت خود هدایت کنید

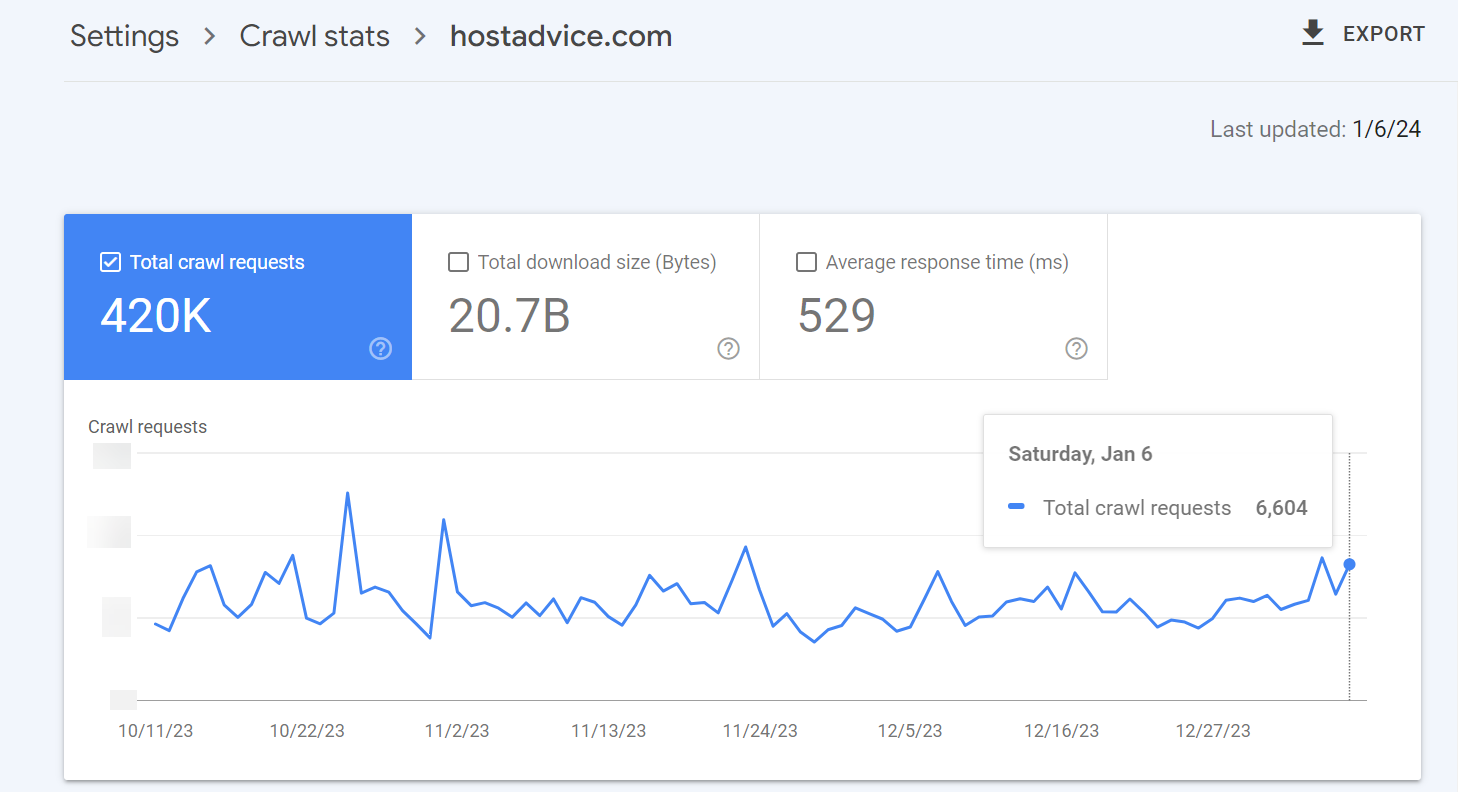

این گزارش به شما نشان میدهد که گوگل روزانه چند صفحه را در سایت شما میخزند.

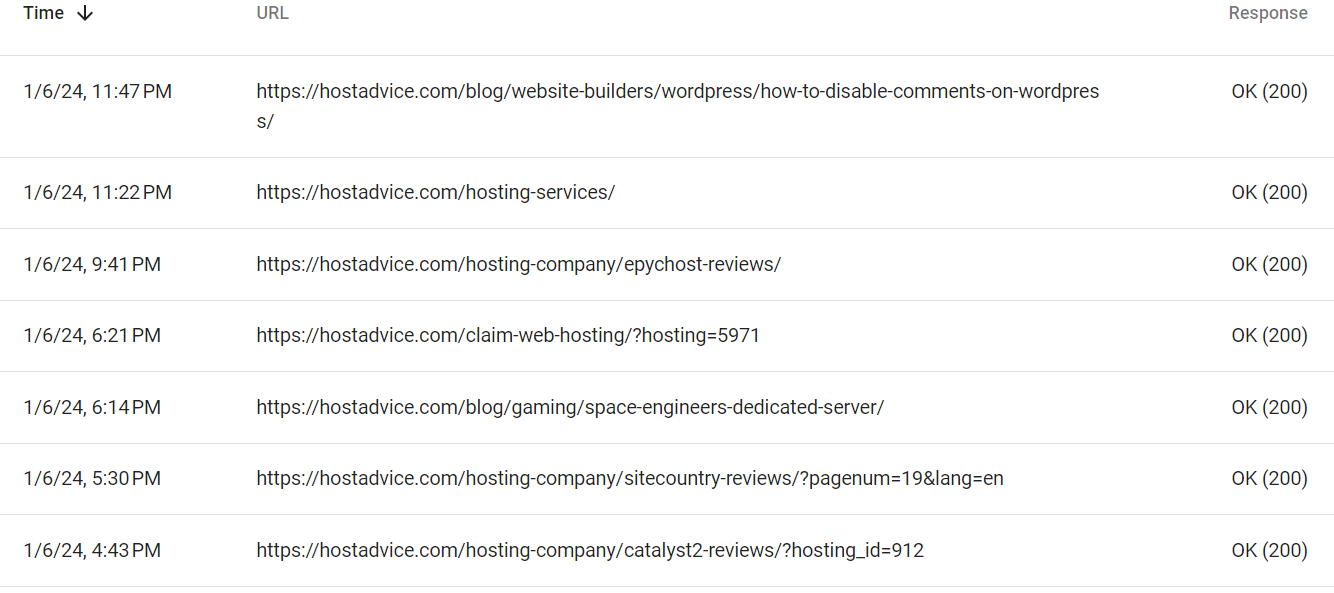

همچنین اطلاعات ثبت شده از آخرین باری که صفحات خزیده شدهاند وجود دارد.

درحالیکه هیچ فرمول نرخ خزیدنی استاندارد عمومی وجود ندارد، میتوانید نرخ خزیدن خود را با تقسیم تعداد کل صفحات نمایه شده در وبسایت خود بر درخواستهای خزیدن روزانه تخمین بزنید. Crawl Budget = (تعداد صفحات نمایه شده) / (درخواستهای خزیدن روزانه)

- نمره بودجه کرال خوب بین ۱ تا ۳ است

- نمره بودجه کرال بین ۳ تا ۱۰ به این معنی است که نیاز به بهبود دارد

- نمره ۱۰ و بالاتر نیاز به توجه و بهینهسازی فوری دارد.

بهعنوانمثال، hostadvice.com دارای ۵۲۹۰۰ صفحه ایندکس شده است و درخواستهای خزیدن روزانه در ۶ ژانویه ۶۶۰۴ بوده است.

این بدان معناست که بودجه کرال ۵۲۹۰۰ ÷ ۶۶۰۴ = ۸.۰۱ است

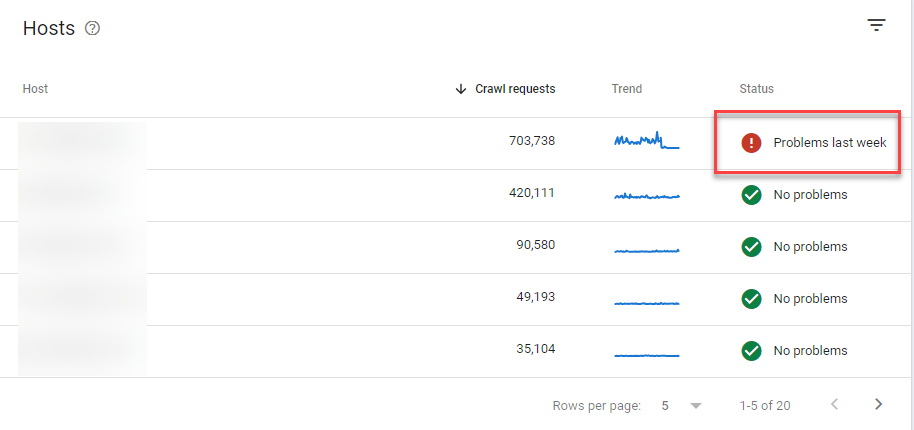

همچنین میتوانید ببینید آیا گوگل در هفته گذشته در سایت شما با مشکل دردسترسبودن خزیدن قابلتوجهی مواجه شده است یا خیر

فایلهای گزارش سرور را تجزیهوتحلیل کنید:

فایلهای گزارش سرور منبع ارزشمندی هستند که بینش جامعی را در مورد هر درخواستی که به وبسایت شما ارسال میشود، ارائه میدهد. با تجزیهوتحلیل کامل این گزارشها، نهتنها میتوانید تعیین کنید که Googlebot چقدر به سایت شما دسترسی پیدا میکند، بلکه همچنین میتوانید از صفحات خاصی که بازدید میکند، زمان این بازدیدها و هر گونه مشکل احتمالی که میتواند بر خزیدن وبسایت شما تأثیر بگذارد، تعیین کنید.

مرحله ۱: دسترسی به فایلهای گزارش سرور

برای شروع تجزیهوتحلیل خود، باید به فایلهای گزارش سرور از وب سرور خود دسترسی داشته باشید و آنها را جمعآوری کنید. این فایلها معمولاً در قالبهایی مانند log. یا txt. ذخیره میشوند و بسته به پیکربندی سرور شما، میتوانند در پوشه اصلی سرور یا پوشه گزارشهای خاص پیدا شوند. بسته به تنظیمات میزبانی خود، ممکن است بتوانید از طریق یک کنترل پنل مانند cPanel یا با استفاده از FTP/SFTP به این گزارشها دسترسی داشته باشید.

مرحله ۲: جمعآوری گزارشها در یک بازه زمانی قابلتوجه

جمعآوری سیاههها در یک دوره معنیدار ضروری است – در حالت ایدئال، حداقل ۳۰ روز. این مدتزمان به شما امکان میدهد تا تغییرات الگوهای ترافیک، تغییرات فصلی و تعداد دفعات فعالیتهای خزیدن Googlebot را ثبت کنید. بازههای زمانی طولانیتر میتوانند بینش عمیقتری ارائه دهند، بهخصوص اگر سایت شما نوساناتی در ترافیک یا بهروزرسانی محتوا داشته باشد.

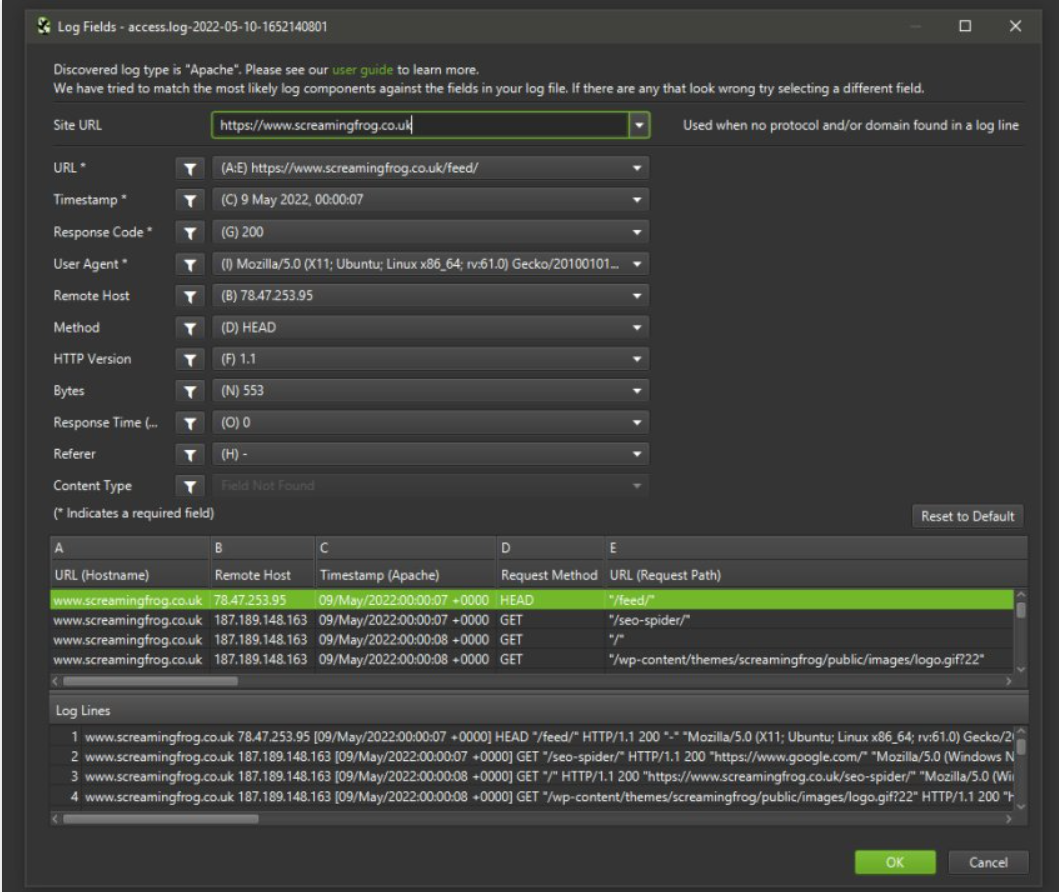

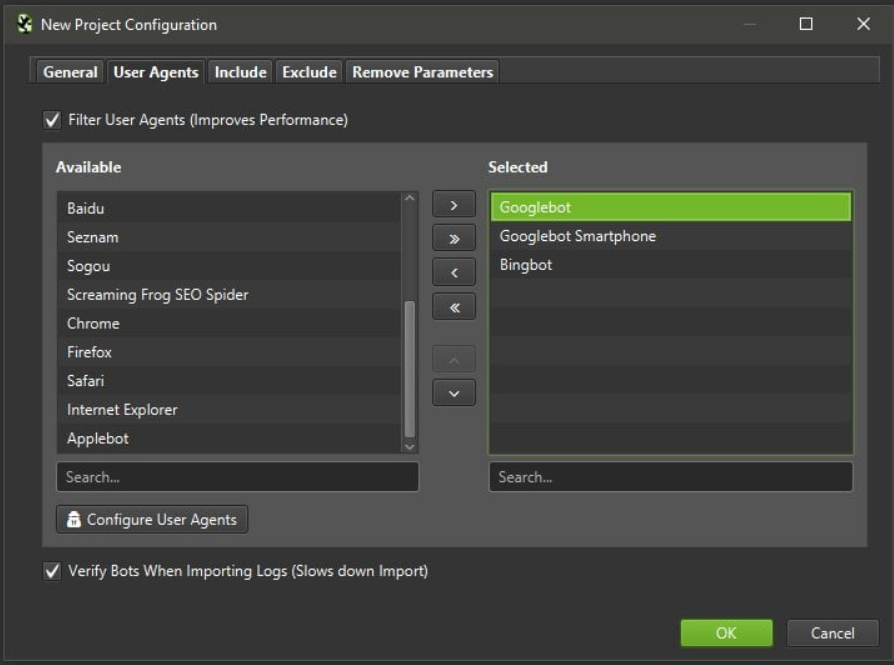

مرحله ۳: از Screaming Frog’s Log File Analyzer استفاده کنید

هنگامی که فایلهای گزارش سرور خود را جمعآوری کردید، گام بعدی استفاده از ابزار قدرتمندی مانند Screaming Frog’s Log File Analyzer است. این ابزار به شما امکان میدهد چندین فایل گزارش را به طور همزمان وارد کنید و تجزیهوتحلیل تجمعی دادههای خزیدن را امکانپذیر میکند.

با Screaming Frog، میتوانید توزیع خزیدن را تجسم کنید، تشخیص دهید که کدام صفحات بیشتر خزیده میشوند، و هر گونه خطا یا تنگناهای احتمالی خزیدن را که ممکن است مانع عملکرد وبسایت شما شوند را تشخیص دهید.

Log File Analyzer فیلترها و گزارشهای مختلفی را ارائه میدهد که به شما امکان میدهد دادهها را بر اساس پارامترهای مختلف مانند کدهای پاسخ، انواع درخواست و عوامل کاربر تقسیمبندی کنید. این تجزیهوتحلیل دقیق میتواند به شما کمک کند تا سایت خود را برای موتورهای جستجو بهینه کنید و استراتژی کلی سئو خود را بهبود بخشید.

مرحله ۴: تفسیر دادهها

پس از واردکردن گزارشهای خود، زمانی را برای تفسیر دقیق دادهها اختصاص دهید. به دنبال الگوهایی در رفتار خزیدن Googlebot باشید، مانند:

فرکانس خزیدن: مشخص کنید کدام صفحات بیشتر خزیده میشوند و آیا این با استراتژی محتوای شما مطابقت دارد یا خیر.

خطاهای خزیدن: هر گونه خطای ۴۰۴ یا ۵۰۰ ثبت شده در گزارشها را بررسی کنید، زیرا اینها صفحاتی را نشان میدهد که ممکن است برای کاربران و موتورهای جستجو غیرقابلدسترسی باشد.

کدهای پاسخ: توزیع کدهای پاسخ را تجزیهوتحلیل کنید تا بفهمید سرور شما چگونه به درخواستها پاسخ میدهد.

با تجزیهوتحلیل و تفسیر مؤثر فایلهای گزارش سرور خود، میتوانید عملکرد وبسایت خود را افزایش دهید، تلاشهای سئوی خود را بهبود بخشید و اطمینان حاصل کنید که موتورهای جستجو میتوانند به طور مؤثر سایت شما را خزیده و فهرستبندی کنند. تجزیهوتحلیل لاگ منظم باید بخشی از استراتژی سئوی شما باشد تا سایت شما را در رتبهبندی جستجو بهینه و رقابتی نگه دارد.

ابزار را برای شناسایی Googlebot یا سایر عوامل کاربری خاص (خزندهها) که علاقه مند به تجزیه و تحلیل آنها هستید پیکربندی کنید. این دادههای نامربوط را با تمرکز بر خزندههای موتور جستجو فیلتر میکند.

به بخش کدهای پاسخ نگاه کنید تا تعداد صفحات خزیده شده (200 OK)، تعداد صفحات منجر به خطا (مانند ۴۰۴) و سایر وضعیتها را شناسایی کنید. مشخص کنید کدام صفحات یا بخشهایی از سایت شما بیشتر و کمتر مورد خزیدن قرار میگیرند. این به درک مناطق تمرکز Googlebot و شناسایی بخشهای نادیده گرفته شده کمک میکند.

فرکانس و روندها را در طول زمان ارزیابی کنید تا ببینید آیا الگوها، اوجها یا کاهشهایی در فعالیت خزیدن وجود دارد یا خیر. اکنون بیایید به این موضوع بپردازیم که چگونه میتوانید سایت خود را بهینهسازی و تنظیم کنید تا هر خزیدن بهحساب بیاید و دید شما را در جایی که بیشترین اهمیت را دارد افزایش دهید.

عوامل مؤثر بر Crawl Budget و نکات بهینهسازی:

عوامل متعددی بر نحوه تخصیص بودجه خزنده توسط گوگل برای یک وبسایت تأثیر میگذارد. درک این موارد میتواند به شما کمک کند نرخ خزیدن خود را برای عملکرد بهتر سئو بهینه کنید.

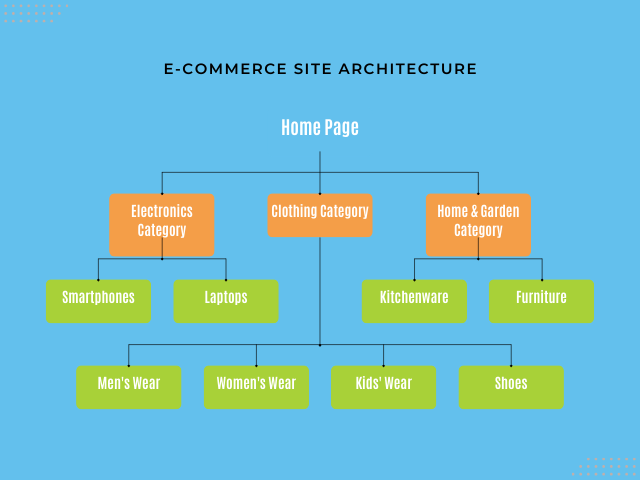

معماری سایت

یک وبسایت با ساختاری واضح و منطقی معمولاً دارای یک سلسلهمراتب ساده است که خزیدن آن برای موتورهای جستجو آسان است. از طرف دیگر، یک ساختار پیچیده و عمیق تودرتو میتواند نرخ خزیدن بیشتری را مصرف کند، زیرا رباتهای گوگل زمان بیشتری را صرف پیمایش و فهرستکردن هر صفحه میکنند.

بهعنوانمثال، یک سایت فروشگاهی با ساختار ساده را در نظر بگیرید:

- صفحه اصلی (Home Page)

- صفحه دسته (بهعنوانمثال، الکترونیک، پوشاک، خانه و باغ) Category Page (e.g., Electronics, Clothing, Home & Garden))

- صفحه زیر مجموعه (در بخش الکترونیک: گوشیهای هوشمند، لپتاپ، تلویزیون) Subcategory Page (under Electronics: Smartphones, Laptops, Televisions))

- صفحات محصول فردی (Individual Product Pages)

در این ساختار، هر صفحه دستهبندی مستقیماً از صفحه اصلی قابلدسترسی است. زیرمجموعهها بیشتر انتخابهای کاربر را اصلاح میکنند و آنها را به صفحات محصول خاص هدایت میکنند.

این رویکرد ساده به رباتهای گوگل اجازه میدهد تا وبسایت را به طور مؤثری بخزند، بدون اینکه با پیچیدگیهای غیرضروری مواجه شوند، از صفحه اصلی به صفحه اصلی به صفحههای دستهبندی، زیرمجموعهها و محصولات حرکت کنند.

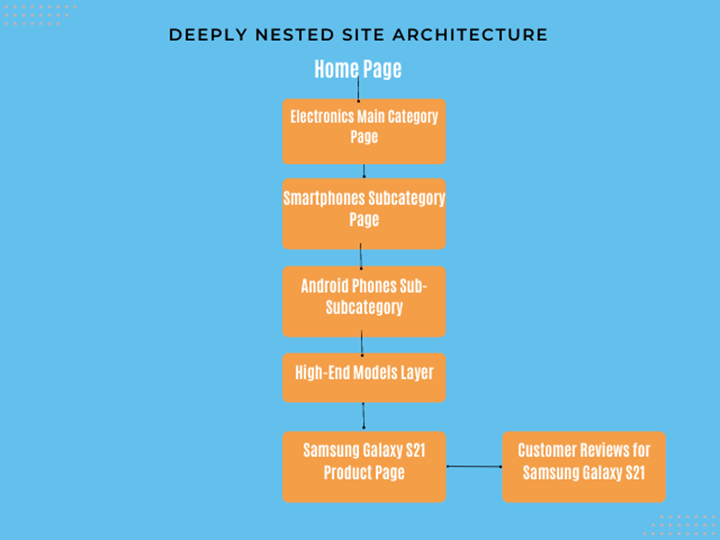

برعکس، یک وبسایت با ساختار پیچیده و عمیقاً تودرتو میتواند به شکل زیر باشد:

صفحه اصلی → صفحه دسته اصلی → صفحه فرعی → لایه زیر شاخه دیگری → لایه دیگری → صفحات محصول فردی → صفحه جزئیات محصول اضافی → صفحه نظرات کاربران

در این سناریو، هم کاربر و هم Googlebot باید در چندین لایه یک وبسایت حرکت کنند تا به محتوای نهایی مانند بررسی محصول خاص دسترسی پیدا کنند.

هر لایه اضافی پیچیدگی را معرفی میکند و به منابع خزنده بیشتری نیاز دارد که به نوبه خود بخش قابلتوجهی از نرخ خزیدن سایت را مصرف میکند. هرچه مسیر ناوبری پیچیدهتر و عمیقتر باشد، خزیدن مؤثر سایت برای رباتهای گوگل چالش برانگیزتر میشود.

این ناکارآمدی میتواند منجر به کندتر شدن زمان نمایهسازی شود و ممکن است منجر به نادیده گرفتهشدن یا نمایهسازی کمتر محتوای مهم شود. در نتیجه، صفحات محصول ضروری، نظرات یا مقالات ممکن است بهسرعت در نتایج جستجو ظاهر نشوند، که به طور بالقوه بر دید و ترافیک تأثیر میگذارد.

چگونه معماری سایت خود را بهینه کنیم:

ساختار سایت کمعمق را هدف بگیرید: اطمینان حاصل کنید که صفحات مهم تنها با چند کلیک از صفحه اصلی قابل دسترسی هستند. این رویکرد ساده به موتورهای جستجو کمک میکند تا این صفحات را به طور موثرتری کشف و فهرستبندی کنند.

سازماندهی محتوا به دستهها و زیرمجموعههای پاک: یک سلسلهمراتب بهخوبی تعریف شده به موتورهای جستجو کمک میکند تا زمینه و ارتباط هر صفحه را درک کنند و احتمال نمایهسازی مناسب را بهبود بخشد.

استفاده از Breadcrumb Navigation: این نهتنها با نشاندادن مسیر طی شده برای رسیدن به یک صفحه، تجربه کاربر را بهبود میبخشد، بلکه یکلایه اطلاعات ساختاری اضافی را نیز در اختیار موتورهای جستجو قرار میدهد.

بهینهسازی ساختار URL: از URL های توصیفی و ساده استفاده کنید، زیرا جستجو و درک آنها برای موتورهای جستجو آسانتر است و در نتیجه شانس فهرستبندی بهتر را بهبود میبخشد.

پیادهسازی پیوند داخلی: این عمل به موتورهای جستجو در کشف صفحات جدید و درک روابط بین بخشهای مختلف سایت شما کمک میکند، که میتواند به توزیع موثرتر نرخ خزیدن کمک کند.

اندازه وبسایت و پیچیدگی:

وبسایتهایی که در مقیاس بزرگتر هستند و هزاران یا میلیونها صفحه را در خود جایدادهاند، طبیعتاً به دلیل حجم بالای محتوایی که نیاز به نمایهسازی دارد، منابع بیشتری را برای خزیدن جامع میخواهند. درحالیکه گوگل نرخ خزیدن بالاتری را برای این سایتهای گسترده اختصاص میدهد، بودجه محدود میتواند منجر به خزیدن مکرر برخی از صفحات شود و منجر به کاهش دید در نتایج جستجو شود.

بهعنوانمثال، غولهای تجارت الکترونیک مانند آمازون یا eBay، با فهرستهای محصولات گسترده و بررسیهای مشتریان، به بودجههای خزیدنی قابلتوجهی نیاز دارند. هر صفحه محصول، صفحه دستهبندی و بررسی مشتری به تعداد کلی صفحاتی که گوگل باید پردازش کند اضافه میکند.

پیچیدگی صفحات وب:

صفحاتی که بهشدت به محتوای پویا یا تولید شده توسط کاربر وابسته هستند، چالشهای منحصربهفردی را برای موتورهای جستجو ایجاد میکنند. بهعنوانمثال، پلتفرمهای رسانههای اجتماعی مانند فیسبوک و توییتر، که بر روی مجموعهای از محتوای تولید شده توسط کاربر ساخته شدهاند، ممکن است به زمان و منابع بیشتری برای خزیدن و فهرستبندی Googlebot در مقایسه با محتوای HTML ثابت نیاز داشته باشند.

وبسایتهایی که دارای عناصر تعاملی هستند، مانند نقشههای تعبیهشده یا قابلیتهای جستجوی پیچیده (مانند مواردی که در سایتهای املاک و مستغلات مانند Zillow یافت میشوند)، به دلیل اتکا به اجرای چند اسکریپت، فرایند خزیدن را پیچیدهتر میکنند.

نحوه بهینهسازی اندازه و پیچیدگی وبسایت:

رندر سمت سرور (SSR): این روش HTML نهایی را برای یک صفحه در سرور قبل از رسیدن به مرورگر ایجاد میکند و اطمینان حاصل میکند که موتورهای جستجو میتوانند به طور مؤثر محتوا را خزیده و فهرستبندی کنند، حتی زمانی که جاوا اسکریپت چالشهایی را ایجاد میکند.

گنجاندن دادههای ساختاریافته: این میتواند بهویژه برای محتوایی که برای نمایش نیاز به تعامل کاربر دارد، مفید باشد، زیرا به موتورهای جستجو زمینه صریح در مورد محتوای صفحه را ارائه میدهد.

سادهسازی عناصر تعاملی: برای سایتهایی با ویژگیهای پویا مانند فیلترهای جستجو یا تورهای مجازی، کاهش پیچیدگی کد و حذف اسکریپتهای اضافی میتواند کارایی خزیدن را افزایش دهد.

محتوای خود را حسابرسی کنید: برای حفظ تازگی و کاهش حجم غیرضروری که ممکن است نرخ خزیدن را مصرف کند، به طور مرتب محتوای قدیمی یا تکراری را شناسایی و حذف کنید.

صفحات یتیم را شناسایی و پیوند دهید: اطمینان حاصل کنید که صفحات یتیم از بخشهای مرتبط سایت شما پیوند داده شده و در نقشه سایت XML شما گنجانده شده است، که میتواند کارایی خزیدن را بهبود بخشد.

فراوانی بهروزرسانی محتوا:

هدف اصلی گوگل ارائه مرتبطترین و بهروزترین اطلاعات به کاربران است. وبسایتهایی که مرتباً محتوای خود را بهروز میکنند به گوگل سیگنال میدهند که احتمالاً اطلاعات جدیدی دارند. در نتیجه، گوگل ممکن است نرخ خزیدن بالاتری را به چنین سایتهایی اختصاص دهد و اطمینان حاصل کند که آخرین محتوای آنها بهسرعت کشف و فهرست میشود.

انواع بهروزرسانی محتوا عبارتاند از:

- انتشار مقالات جدید، پستهای وبلاگ یا مقالات تحقیقاتی.

- بازنگری مقالات موجود برای بهروزرسانی حقایق یا بهبود سئو.

- افزودن محصولات جدید یا اصلاح توضیحات، قیمتها یا سطوح موجودی.

- بهروزرسانی فیدهای خبری، رویدادهای آینده، یا معاملات روزانه.

- ارسال نظرات یا بررسیهای جدید در انجمنها و پلت فرمهای رسانههای اجتماعی.

سرعت سرور و زمان پاسخگویی:

وبسایتهایی که بهسرعت بارگیری میشوند، Googlebot را قادر میسازند تا صفحات بیشتری را در زمان کمتری بخزد. زمان پاسخ سریع سرور به این معنی است که به هر درخواستی که توسط Googlebot ارسال میشود، بهسرعت پاسخ داده میشود و به آن اجازه میدهد بدون تأخیر غیرضروری به صفحه بعدی برود.

این کارایی برای وبسایتهای بزرگتر بسیار مهم است، زیرا احتمال پوشش کاملتر در بودجه اختصاصیافته را افزایش میدهد. برعکس، زمان پاسخ آهسته سرور – ناشی از بارگذاری بیش از حد سرورها، کد ناکارآمد یا میزبانی ناکافی – میتواند به طور قابلتوجهی روند خزیدن را مختل کند.

نحوه بهینهسازی سرعت سرور و زمان پاسخگویی:

ارتقاهاست: اگر منابع میزبانی فعلی کافی نیست، مهاجرت به راهحلهای میزبانی قویتر، مانند میزبانی اختصاصی یا ابری را در نظر بگیرید، که معمولاً عملکرد بهتری نسبت به هاست اشتراکی ارائه میدهد.

پیادهسازی حافظه پنهان: از کش سمت سرور برای ذخیره محتوایی که اغلب به آنها دسترسی دارید در حافظه، کاهش بار سرور و سرعتبخشیدن به زمان پاسخ برای بازدیدکنندگان بازگشتی استفاده کنید.

بهینهسازی پرسوجوهای پایگاهداده: بررسی و سادهسازی پرسوجوهای پایگاهداده برای اطمینان از کارآمد بودن آنها، زیرا پرسوجوهای طولانی یا پیچیده میتوانند زمان پاسخگویی سرور را کاهش دهند.

بهحداقلرساندن درخواستهای HTTP: تعداد درخواستهای HTTP لازم برای بارگذاری صفحات را با ترکیب فایلها، استفاده از CSS sprites و بهحداقلرساندن استفاده از اسکریپت و افزونه کاهش دهید.

شبکه تحویل محتوا (CDN): از CDN برای توزیع بار محتوا، بهویژه برای وبسایتهایی با مخاطب جهانی استفاده کنید. CDN ها محتوا را در مکانهای مختلف ذخیره میکنند و سرعت تحویل را برای کاربران بدون توجه به موقعیت جغرافیایی آنها بهبود میبخشد.

بهینهسازی تصاویر و فایلهای رسانهای: برای کاهش حجم فایل و افزایش زمان بارگذاری، تصاویر و فایلهای رسانهای را بدون کاهش کیفیت فشرده کنید.

کوچککردن CSS، جاوا اسکریپت و HTML: کاراکترهای غیرضروری را از این فایلها حذف کنید تا اندازه آنها کاهش یابد و در نتیجه سرعت بارگذاری به میزان قابلتوجهی بهبود یابد.

پیوندهای شکسته و زنجیرههای تغییر مسیر:

لینکهای شکسته، هایپرلینکهایی هستند که منجر به صفحات غیر موجود میشوند و اغلب منجر به خطای ۴۰۴ میشوند. وقتی Googlebot با این پیوندها روبرو میشود، زمان و منابع ارزشمندی را برای دسترسی به محتوایی که دیگر در دسترس نیست تلف میکند. این ناکارآمدی به این معنی است که تعداد صفحات فعال کمتری را میتوان با همان نرخ خزیدن کرد.

این امر بهویژه برای وبسایتهای بزرگتر که در آن به حداکثر رساندن پوشش نرخ خزیدن برای نمایهسازی جامع حیاتی است بسیار مهم است.

ممیزی منظم سایت شما برای شناسایی و رفع لینکهای شکسته و زنجیرههای تغییر مسیر برای حفظ کارایی بهینه خزیدن و اطمینان از اینکه همه محتوای ارزشمند برای کاربران و موتورهای جستجو قابل دسترسی است ضروری است. با ایجاد یک ساختار وبسایت سالم، میتوانید هم تجربه کاربر و هم دید موتور جستجو را افزایش دهید و در نهایت منجر به عملکرد بهتر در نتایج جستجو میشود.

چگونه لینکهای شکسته را برای خزیدن بهتر بودجه رفع کنیم؟

به طور منظم پیوندهای شکسته را اسکن کنید : از ابزارهایی مانند کنسول جستجوی گوگل یا Screaming Frog SEO Spider برای شناسایی مرتب لینکهای شکسته در وبسایت خود استفاده کنید.

رفع یا حذف : پیوندهای شکسته را با بهروزرسانی با نشانی اینترنتی صحیح، سریعاً اصلاح کنید یا اگر محتوای پیوند شده دیگر وجود نداشت، آنها را حذف کنید.

بهروزرسانی محتوا: اگر پیوند شکسته به محتوایی اشاره دارد که منتقل شده است، آن را با URL جدید بهروز کنید تا یکپارچگی پیوند حفظ شود.

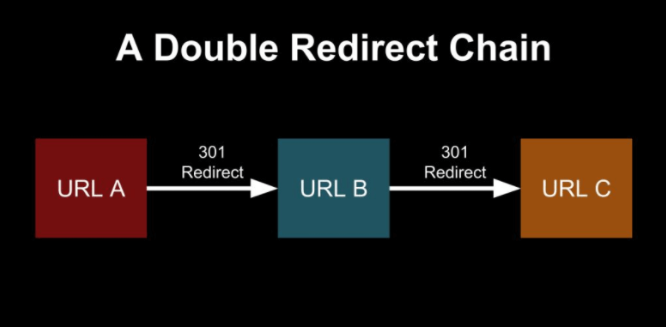

تغییر مسیر زنجیرهها:

زنجیرههای تغییر مسیر زمانی رخ میدهند که یک صفحه وب به صفحه دیگری هدایت میشود، سپس به صفحه دیگری هدایت میشود و پیش از رسیدن به مقصد نهایی، دنبالهای از تغییر مسیرها را تشکیل میدهد.

زنجیرههای تغییر مسیر برای هر تغییر مسیر در زنجیره، منابع اضافی را مصرف میکنند.

Googlebot باید هر تغییر مسیر را گامبهگام دنبال کند، که میتواند روند خزیدن را کند کرده و تعداد صفحاتی را که میتواند در بودجه اختصاص داده شده ایندکس کند کاهش دهد.زنجیرههای تغییر مسیر طولانی همچنین میتوانند منجر به خطاهای خزیدن شوند و کارایی خزیدن را بیشتر کاهش دهند.

چگونه میتوان زنجیرههای تغییر مسیر را برای نرخ خزیدن بهتر برطرف کرد؟

زنجیرههای تغییر مسیر را شناسایی کنید: از ابزارهای SEO برای پیداکردن و ترسیم زنجیرههای تغییر مسیر در سایت خود استفاده کنید.

تغییر مسیرها را ساده کنید : زنجیرههای تغییر مسیر طولانی را با اطمینان از اینکه مستقیماً از URL اصلی به URL مقصد نهایی مرتبط میشوند، کوتاه کنید.

بهروزرسانی پیوندهای داخلی: هر پیوند داخلی را که به زنجیره تغییر مسیر کمک میکند تغییر دهید تا مستقیماً به URL نهایی اشاره کند و از تغییر مسیرهای غیرضروری دور بزنید.

نقشهی سایت:

نقشه سایت فایلی است که همه نشانیهای اینترنتی یک وبسایت را فهرست میکند و بهعنوان راهنمای موتورهای جستجو برای یافتن و فهرستبندی محتوای آن عمل میکند. یک نقشه سایت بهخوبی سازماندهی شده به Googlebot امکان میدهد تا محتوای مهم را به طور موثرتری کشف و فهرستبندی کند و از نرخ خزیدن اختصاص داده شده استفاده بهتری کند.

بهعلاوه، نقشههای سایت میتوانند به Googlebot کمک کنند تا محتوای جدید یا بهروز شده را بهسرعت شناسایی کند، بهویژه در وبسایتهای بزرگ که ممکن است به دلیل محدودیتهای نرخ خزیدن، محتوا نادیده گرفته شود.

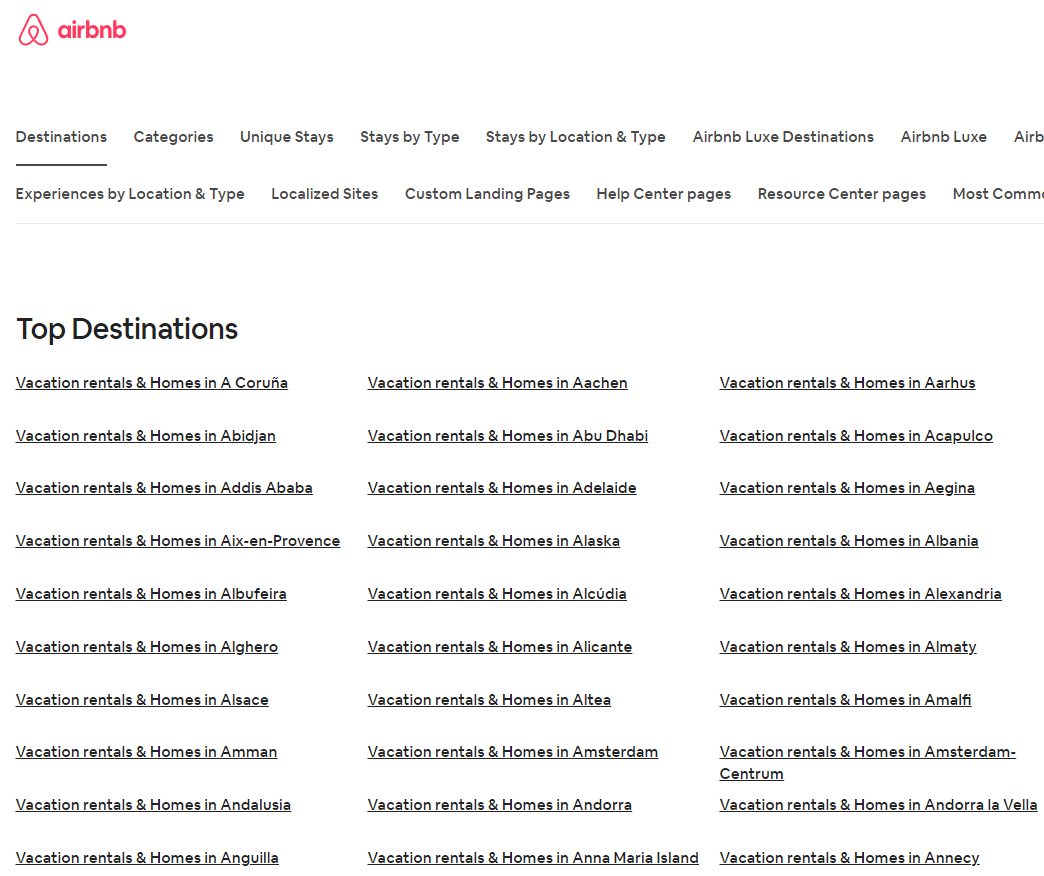

برای مثال، نقشه سایت HTML Airbnb نمونهای از نقشه سایت سازمانیافته است. این یک ساختار واضح و جامع ارائه میدهد که تمام مناطق مهم وبسایت را پوشش میدهد.

خطاهایی در نقشه سایت شما مانند URL های نادرست، لینکهای شکسته، یا ارجاع به صفحاتی که دیگر وجود ندارند، میتواند مانع از کشف و نمایهسازی محتوای سایت شما توسط Googlebot شود. این نظارت میتواند بهشدت بر توانایی سایت شما برای رتبهبندی مؤثر در نتایج موتورهای جستجو تأثیر بگذارد، زیرا ممکن است گوگل تمام محتوای موجود را تشخیص ندهد، که منجر به ازدسترفتن فرصتهای دید و ترافیک میشود.

چگونه خطاهای نقشه سایت را برای خزیدن بهتر بودجه رفع کنیم؟

حذف URL های نادرست: خطاهای تایپی یا نحوی را در URL های خود بررسی کنید. اطمینان حاصل کنید که هر URL در نقشه سایت به طور دقیق به صفحه مربوطه خود اشاره میکند تا از هدایت Googlebot به مکانهای ناموجود یا نادرست جلوگیری شود.

حذف لینکهای شکسته: هر پیوندی که صفحه خطای ۴۰۴ ایجاد میکند را شناسایی و حذف کنید. لینکهای شکسته میتوانند موتورهای جستجو را گیج کنند و تجربه کاربری را از بین ببرند و در نهایت به اعتبار سایت شما آسیب بزنند.

حذف لینکهای قدیمی: نقشه سایت خود را بهروز کنید تا هرگونه تغییر در URL ها، از جمله مواردی که تحت ۳۰۱ تغییر مسیر قرار گرفتهاند، منعکس شود. این تضمین میکند که Googlebot به جدیدترین نسخههای صفحات شما دسترسی دارد و از خطاهای غیرضروری جلوگیری میکند.

حذف URL های غیرمتعارف: نسخههای تکراری یا غیرمتعارف URL ها را از نقشه سایت خود حذف کنید. این کمک میکند تا مشخص شود کدام نسخه از صفحه باید ایندکس شود، و شانس رقیقشدن سیگنالهای رتبهبندی موتورهای جستجو را کاهش میدهد.

حذف URL های مسدود شده: اطمینان حاصل کنید که URL های مسدود شده توسط فایل robots.txt یا متاتگها در نقشه سایت شما گنجانده نشده است. گنجاندن چنین نشانیهای اینترنتی میتواند ربات گوگل را گمراه کند و نرخ خزیدن را در صفحاتی که ایندکس نمیشوند هدر دهد.

تقسیم نقشه سایت بزرگ: اگر نقشه سایت شما بیش از ۵۰ مگابایت است یا حاوی بیش از 50.000 URL است، آن را به نقشههای سایت کوچکتر و مبتنی بر موضوع تقسیم کنید. این سازمان خزیدن و فهرستبندی مؤثر محتوای شما را برای موتورهای جستجو آسانتر میکند.

حذف صفحات غیر ایندکس شده: از فهرستکردن صفحاتی در نقشه سایت خود که برای نمایهسازی در نظر گرفته نشدهاند خودداری کنید، مانند ورود به سیستم یا صفحات مدیریت داخلی. این کمک میکند تا توجه Googlebot روی محتوایی که واقعاً برای سئو مهم است متمرکز شود.

جمع بندی:

درک و بهینهسازی Crawl Budget وبسایت شما برای بهبود دیدهشدن آن در نتایج موتورهای جستجو بسیار مهم است. تأثیر متقابل بین محدودیتهای سرعت خزیدن و تقاضای خزیدن میتواند به میزان قابلتوجهی بر میزان مکرر و مؤثر ایندکسشدن سایت شما تأثیر بگذارد. برای به حداکثر رساندن ب خود، ساختار سایت خود را ساده کنید، از محتوای تازه و جذاب اطمینان حاصل کنید و یک نقشه سایت تمیز و دقیق داشته باشید.

علاوه بر این، انتخاب هاستینگ وب نقشی اساسی در این فرایند ایفا میکند. انتخاب یک ارائهدهندههاست قابلاعتماد و سریع میتواند زمان پاسخگویی سرور را افزایش دهد و به استفاده کارآمدتر از Crawl Budget کمک کند.

با اولویتبندی این عناصر، نهتنها میتوانید تلاشهای سئوی خود را تقویت کنید، بلکه میتوانید رتبه سایت خود را در موتورهای جستجو و دید کلی آنلاین خود را افزایش دهید. فعال ماندن در مدیریت نقشه سایت و ساختار وبسایت برای اطمینان از اینکه محتوای شما به مخاطبی که شایسته آن است برسد، کلیدی است.

سؤالات متداول:

گوگل هر چند وقت یکبار در یک سایت خزش میکند؟

فرکانس خزیدن گوگل بر اساس چندین عامل از جمله اندازه سایت، محبوبیت و سرعت بهروزرسانی محتوا میتواند به طور قابلتوجهی متفاوت باشد. وبسایتهای بزرگ و جاافتاده با ترافیک بالا و بهروزرسانیهای مکرر ممکن است چندین بار در روز خزیده شوند و اطمینان حاصل شود که آخرین محتوای آنها بهسرعت ایندکس میشود.

در مقابل، سایتهای کوچکتر یا کمتر فعال ممکن است بسته به ارتباط و فعالیت آنها فقط بهصورت هفتگی یا حتی با دفعات کمتر خزیده شوند. الگوریتمهای پیچیده گوگل نرخ خزیدن بهینه را برای هر سایت ارزیابی میکند و نیاز به نمایهسازی بهموقع محتوا را با لزوم بارگذارینکردن بیش از حد سرور سایت متعادل میکند. بهعلاوه، سایتهایی که در بهروزرسانیهای مداوم محتوایی مانند وبلاگها یا رسانههای خبری شرکت میکنند، احتمالاً خزندههای مکرر بیشتری را جذب میکنند.

چگونه گوگل را وادار به خزیدن در سایت خود کنیم؟

برای تشویق گوگل به خزیدن بیشتر سایت شما، با ارسال URL خود از طریق کنسول جستجوی گوگل، از ایندکسشدن آن اطمینان حاصل کنید. این ابزار نهتنها به شما امکان میدهد URL های جدید ارسال کنید، بلکه بینشهایی را نیز در مورد نحوه مشاهده سایت توسط گوگل ارائه میدهد.

بهروزرسانی منظم سایت خود با محتوای تازه و باکیفیت ضروری است. موتورهای جستجو سایتهایی را ترجیح میدهند که فعالیت و ارتباط مداوم را نشان میدهند. حفظ ساختار سایت تمیز و کارآمد، همراه با یک سیستم کاربرپسند، میتواند خزیدن آسانتر را نیز تسهیل کند.

استفاده از نقشه سایت XML دقیق و بهروز بسیار مهم است، زیرا به Googlebot کمک میکند تمام صفحات سایت شما را بهسرعت کشف کند. علاوه بر این، دریافت بکلینکهای باکیفیت از وبسایتهای معتبر میتواند اعتبار سایت شما را افزایش دهد و منجر به خزیدن مکرر شود. مشارکت در تبلیغات رسانههای اجتماعی و بهاشتراکگذاری محتوای شما نیز میتواند باعث افزایش ترافیک شود و به طور غیرمستقیم بر نرخ خزیدن تأثیر بگذارد.

خزیدن یک صفحه جدید توسط گوگل چقدر طول میکشد؟

مدت زمانی که گوگل برای خزیدن یک صفحه جدید طول میکشد میتواند از چند روز تا چند هفته متغیر باشد و این مدت تحتتأثیر عوامل مختلفی قرار دارد. عناصر کلیدی شامل نرخ خزیدن کلیسایت است که تعیین میکند Googlebot در طول هر بازدید چند صفحه را بخزد.

موقعیت صفحه در ساختار سایت؛ و اینکه چقدر سایت با محتوای جدید بهروز میشود. بهطورکلی، محتوای باکیفیت بالا در سایتهای معتبر، سریعتر از سایتهای جدیدتر یا کمتر معتبر خزیده میشود. برای تسریع احتمالی روند خزیدن، میتوانید صفحات جدیدی را از طریق کنسول جستجوی گوگل ارسال کنید، که میتواند به گوگل نشان دهد که محتوای جدیدی برای فهرستبندی در دسترس است.

علاوه بر این، درگیرشدن در شیوههایی که لینکسازی را ترویج میکنند نیز میتواند کمک کند.

آیا گوگل هر وبسایتی را خزش میکند؟

درحالیکه گوگل تلاش میکند تا جایی که ممکن است وبسایتها را بخزد، تضمین نمیکند که تک تک سایتها خزیده شوند. عوامل متعددی بر این فرایند تأثیر میگذارند، از جمله دسترسی سایت، تنظیمات فایل robots.txt و کیفیت کلی محتوا. سایتهایی که توسط فایلهای robots.txt مسدود شدهاند یا مشکلات فنی مهمی دارند، ممکن است از خزیدن حذف شوند. علاوه بر این، برخی از وبسایتها، بهویژه آنهایی که جدید هستند یا محتوای کمی دارند، ممکن است بلافاصله توسط رباتهای گوگل کشف نشوند.

همچنین توجه به این نکته مهم است که سایتهایی با پیکربندی ضعیف یا محتوای باکیفیت پایین ممکن است برای خزیدن در اولویت قرار گیرند. برای افزایش احتمال خزیدن، اطمینان حاصل کنید که سایت شما در دسترس است، ساختار واضحی دارد و اطلاعات ارزشمندی را ارائه میدهد که با اهداف جستجوی کاربران همسو میشود.